У понад 140 модераторів контенту Facebook, які працювали в Кенії, діагностували посттравматичний стресовий розлад (ПТСР) через постійний вплив графічного контенту, включаючи вбивства, самогубства, дитяче насильство та тероризм.

Про це повідомляє The Guardian.

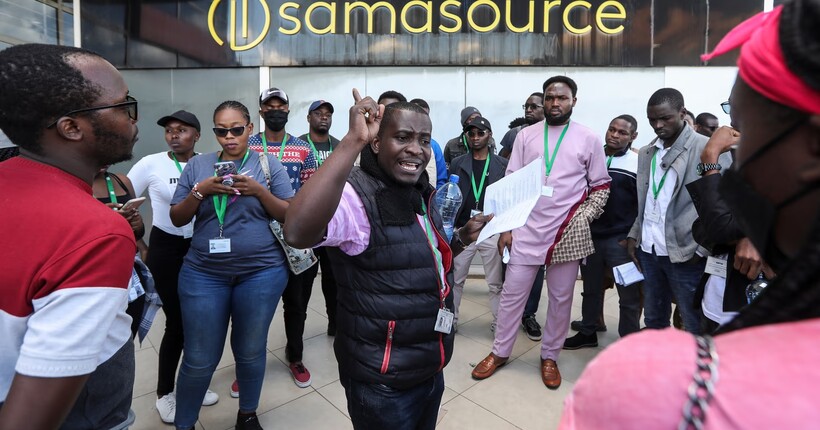

Майже 190 модераторів подали позов до суду проти Meta та компанії Samasource, яка забезпечувала модерацію контенту в Африці. Вони працювали по вісім - десять годин переглядаючи жорстокі відео та зображення. У всіх 144 осіб, обстежених Каньяною, було виявлено ПТСР, ГТР і МДР, у 81% випадків виявлено тяжкі симптоми розладу, переважно через рік після звільнення. У деяких працівників розвинулися унікальні фобії, наприклад тріпофобія, спричинена переглядом зображень тіл із дірками на розкладених тканинах.

Через умови праці багато модераторів стикнулися із залежністю від алкоголю, наркотиків і медикаментів, розпадом сімей і відчуженням. Деякі боялися, що після видалення відео терористичних угрупувань їх переслідуватимуть і вб’ють.

Марта Дарк, засновниця Foxglove, заявила:

“Модерація Facebook — це небезпечна робота, яка викликає ПТСР у майже всіх працівників. У будь-якій іншій галузі такі масштабні порушення прав людей спричинили б масові відставки та судові наслідки”.

Meta зазначає, що контракти передбачають психологічну підтримку, доступ до приватної медицини та високий рівень оплати праці. Компанія також використовує технології, такі як розмиття й чорно-біле відображення, щоб мінімізувати вплив графічного контенту.

Як повідомляв “Ми-Україна” раніше, восени 2023 року в східній частині Демократичної Республіки Конго медики виявили перший випадок mpox, що став початком масштабного спалаху. Через 15 місяців вірус поширився на шість країн Африки та зафіксований у Європі, Азії й Північній Америці.